作为数据中心继CPU和GPU之后的第三颗主力芯片,DPU近年来热度持续提升。

DPU,即数据处理器,具备强大网络处理能力,以及安全、存储与网络卸载功能,可释放CPU算力,能够完成CPU所不擅长的网络协议处理、数据加解密、数据压缩等数据处理任务,并对各类资源分别管理、扩容、调度,即处理“CPU做不好,GPU做不了”的任务,实现数据中心降本提效。

在AI时代,智算中心需要处理的数据量井喷,DPU能够释放智算中心的有效算力,能够解决基础设施的降本增效问题,重要性和渗透率正逐渐提升。

三U一体,更适配智算时代的解决方案

“DPU这个概念是四年前被英伟达炒作起来的。在收购了以色列公司Mellanox后,英伟达一跃成为业界首个既有CPU、GPU,也有DPU的数据中心完整解决方案的供应商。”芯启源创办人卢笙在接受第一财经专访时表示,芯启源是国内最早一批从事DPU研发的厂商之一,可以追溯到2018年,那个时候还称为智能网卡Smartnic。

“过去承载网络传输功能的是传统网卡,后来诞生了智能网卡,四年前逐步演化为DPU。” 专注于智能计算芯片研发设计的中科驭数(北京)科技有限公司高级副总裁张宇告诉第一财经。

2020年,英伟达发布的DPU产品战略中将其定位为数据中心继CPU和GPU之后的“第三颗主力芯片”,自此引爆了DPU概念。

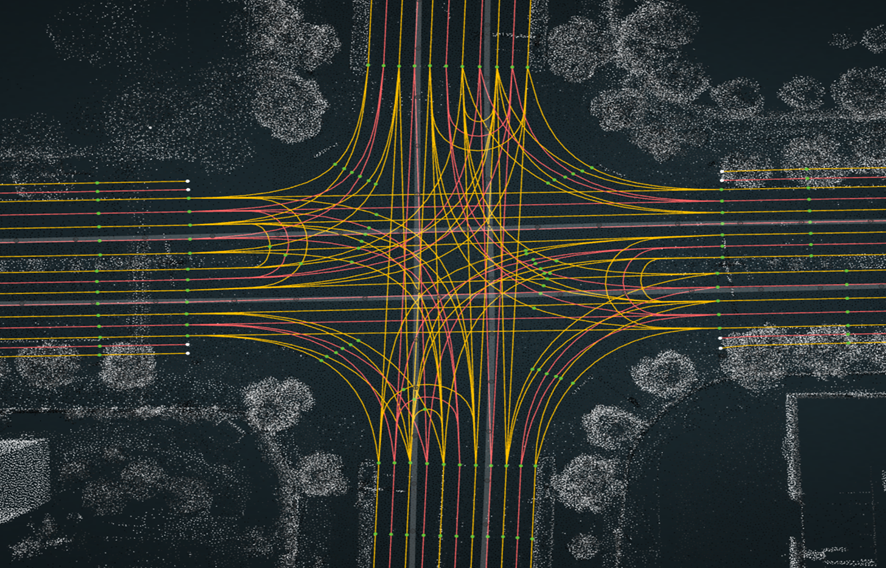

如今,DPU已成为数据中心内新兴的专用处理器,专门设计用于加速数据中心中的安全、网络和存储任务,针对高带宽、低延迟的数据密集型计算场景提供动力。DPU的核心作用是接管原本由CPU处理的网络、存储、安全和管理等任务,从而释放CPU资源,并加强数据安全与隐私保护。

“英伟达所做的智算中心的方案,其实都是三U一体的。英伟达三年前的DGX A100服务器、后面的DGX GH200等一系列,都是包含CPU、GPU和DPU的。当然DPU里还有像RDMA这种智能网卡,这些其实都可以归为DPU,它们本质上是一个东西。所以从这个角度看,当前行业内引领的,或者说大家公认的方向,是在智算中心里CPU加GPU加DPU三者协同。”张宇表示,通用数据 中心的方案则更多是CPU加存储加网络,一些云原生场景里对低时延高吞吐的数据网络处理也是刚需,智算场景对网络处理性能要求更高。

“如果把CPU比喻为大脑,用于整体控制,那么GPU则更像是肌肉,用于提供坚实的充沛的并行计算的算力,而DPU则更像是血管和神经,将GPU需要算的数据,通过DPU运输到服务器中,完成控制指令交换和协议转换。”张宇称。

“多PU的配合实际上是整体计算架构的升级,从过去以通用CPU为主的架构走向加速器为主的计算架构,通过CPU、GPU、DPU、NPU等配合来提升整体计算方案的性价比。”张宇表示,“目前在技术方面,DPU已经逐步趋向成熟,边界也比较成熟。网络安全加解密、零信任、网络卸载,已经基本上成为了DPU稳定承载的功能。”

减少capex投入和能耗,具有一定性价比

作为CPU的卸载引擎,DPU最直接的作用是接管网络虚拟化、硬件资源池化等基础设施层服务,释放CPU的算力到上层应用,因此能够有效释放智算中心的算力,提升能效比。

“英伟达此前承认其上一代生成式AI服务器的算力芯片的效率只有设计能力40%,我们测下来只有30%多,这意味着大部分算力是被闲置的,究其原因主要是在集群间等待计算产生的中间变量完成数据同步,网络通路的能力限制了算力底座的上限,而这恰恰是DPU的真正价值所在。”卢笙表示,这使得DPU又被推到风口浪尖。

在数据量爆炸的AI时代,DPU不仅能够协助构建兼具低时延、大带宽、高速数据通路的新型算力底座,还能够安全高效地调度、管理、联通这些分布式CPU、GPU资源,从而释放智算中心的有效算力。因此,DPU的部署能够减少数据中心的一次性capex(资本性支出)投入。Cisco(思科)的数据显示,通过虚拟化技术,企业可以减少高达40%的服务器数量,同时提高资源利用率。

另一方面,DPU通过专用硬件加速网络、安全和存储任务,提高了数据中心的能效。

卢笙介绍,以中国移动在浙江省SD-WAN这一个应用场景为例,“通过芯启源DPU网卡打造的软硬件一体化解决方案,实现了网络安全业务卸载,相较于传统纯软件SD-WAN网络方案,单机效率提升了6-8倍,整体项目也节约了80%的服务器部署投入和每年的软件费用等,极大降低了CAPEX投入;此外,由于机器部署减少,数据中心的能耗降低,经测算每年可以节省超300万度电,同时极大降低了数据中心的运营成本。”

成本方面,第一财经了解到,DPU的研发和生产成本相对较高,特别是使用先进工艺时,因而价格较高,但由于部署DPU解决方案,既能够减少服务器设备数量,也能在后续运行计算过程中节省能耗,因此整体系统成本上仍然具备一定性价比,但也要根据具体场景和应用情况来讨论。

未来三年是商用落地的关键时期

不过,目前DPU的渗透率提升仍面临阻力。

专注于硬科技领域早期投资的创投机构中科创星相关人士告诉第一财经,DPU作为软硬件协同的虚拟化架构,需要与CPU中运行的虚拟化软件栈进行有效对接,同时,DPU的硬件设计必须考虑到与现有系统的兼容性和集成性;其次,DPU的架构和接口尚未形成统一标准,不同厂商的产品存在差异,这给用户在使用、维护和升级时带来挑战;此外,软件生态尚未成熟,缺乏完善的开发工具、驱动程序和操作系统支持,“但目前已经有公司在做”。

卢笙表示,DPU需要专用的高效指令集,这也是其核心竞争力所在,剩下三分之二的工作则是围绕指令集打造生态,生态建设是DPU行业的核心壁垒,生态建设的成熟度决定了产品商业化落地的速度。

整体来看,DPU产业目前仍以国外企业为主导,三大巨头英伟达、博通和英特尔的份额占比较高,亚马逊、微软这些科技公司也在跟进。国内方面,中国移动、阿里等大企业也在研发专用的DPU,初创企业如芯启源、中科驭数、大禹智芯等也取得了相应的成果或进步。

“国内外的DPU技术发展处于同一阶段,但国外企业积累更深厚一些。在我看来,DPU产业其实已经逐步走向成熟和快速落地的阶段。国外可能比国内可能走得更早更快一点。”张宇表示。

在DPU商业化落地方面,目前国内仅有华为、阿里、中兴等大型云厂商,以及芯启源、中科驭数等少数DPU新势力已实现商用。信通院预计,2025年我国数据中心DPU渗透率可达到12.7%。

张宇认为,DPU走到当前阶段,更重要是与云在IaaS这一层的深度融合,尤其是如何给客户提供全面、便捷、透明的纯软件的IaaS方案,使他们能够平滑地迁移到用DPU来支撑这种高能效比的云方案。

“这块的迁移需要行业的共同努力,并且需要持续很长时间,甚至要以年来计。”张宇称,“亚马逊云就走得比较快,他们研发实力比较强,已经完成了IaaS on DPU的转换,但对国内大部分企业来说,步伐不会迈得太大,可能会从最痛的几个点先透明地用起来,比如OVS卸载、网络升级等。”

“DPU的商业化不仅仅依靠于传统数据中心的IaaS领域,也包括网络安全、高性能存储、集群通信等诸多的行业和领域。”卢笙表示,芯启源多年来深耕“DPU for Security”方向,将DPU应用于诸如防火墙、安全网关等产品,目前已进入深信服网安产品线,成为标配扩展卡,解决了诸如Intel CPU大象流处理能力不足等业界难题。

“从目前的产业发展趋势来看,如果技术发展符合预期,大概2025-2027年会有一个爆发。”上述中科创星相关人士表示,原因在于,随着数字经济、AI和云计算产业的发展,服务器市场会迎来一个增长,尤其是在金融、政府和电力用户领域,不仅需要大量的DPU来处理数据,提升计算效率,还需要DPU发挥安全性的优势。

“DPU芯片确实已经大规模应用了,目前的增速在每年20%-30%。但DPU的行业特质就是需要保持稳定性,需要稳定在集群上运行几个月再扩集群。”张宇表示,更重要的一点,结合国内信创行业的发展来看,这两三年会是非常关键的时期,是每家DPU厂商都需要把握好的关键时间窗口。

“DPU还不是一个标准化的产品,商业化上量的过程需要结合市场的需求和不同应用场景的深入打磨,需要上下游厂家协同,从几百片小规模试点到上万片的大规模部署需要积跬步至千里。”卢笙表示,DPU的商业化需要全行业伙伴共同努力,加强彼此的生态互信与合作,在国产化CPU GPU DPU的3U一体商业化之路携手前行。

帮企客致力于为您提供最新最全的财经资讯,想了解更多行业动态,欢迎关注本站。